我们的大脑如何处理语言?

总结

毫无疑问,人类在如此短的时间内产生令人印象深刻的语言的能力是非常特别的。根据Ted-ed视频"我们的大脑如何解释语言?",我们现在可以更好地理解语言理解的点杂性。一个典型的20岁年轻人能在不到一秒的时间内说话,并拥有27,000到52,000个词的词汇量。由于我们的大脑能够快速做出决定,并且98%的时间都是正确的,理解它的工作原理就变得至关重要。这个视频的主要观点是,就像GPU一样,我们的大脑擅长并行处理。让我们首先假设我们的大脑包含一个语言单元,它会评估传入语音中包含某个词的可能性。大脑中的每个词处理单元类似于大脑皮层中一组神经元的发射模式。我们一听到一个词的开头就开始对其具体含义做出假设。例如,如果一个词以"pro"开头,它可能指的是教授(professor)、专业人士(professional)或可能性(possibility)。而在听到更多的词后,你可能就能识别出它来。此外,你的大脑会在活跃单元暂时禁用其他未激活单元几毫秒的同时,努力确定这个词的含义。我们可以通过上下文更好地理解句子的确切含义。理解我们如何学习新词也很重要。海马体,虽然离主要语言处理系统很远,但会首先存储新词。经过多个晚上的睡眠后,新词和旧词都会链接到语言处理网络中。

思考

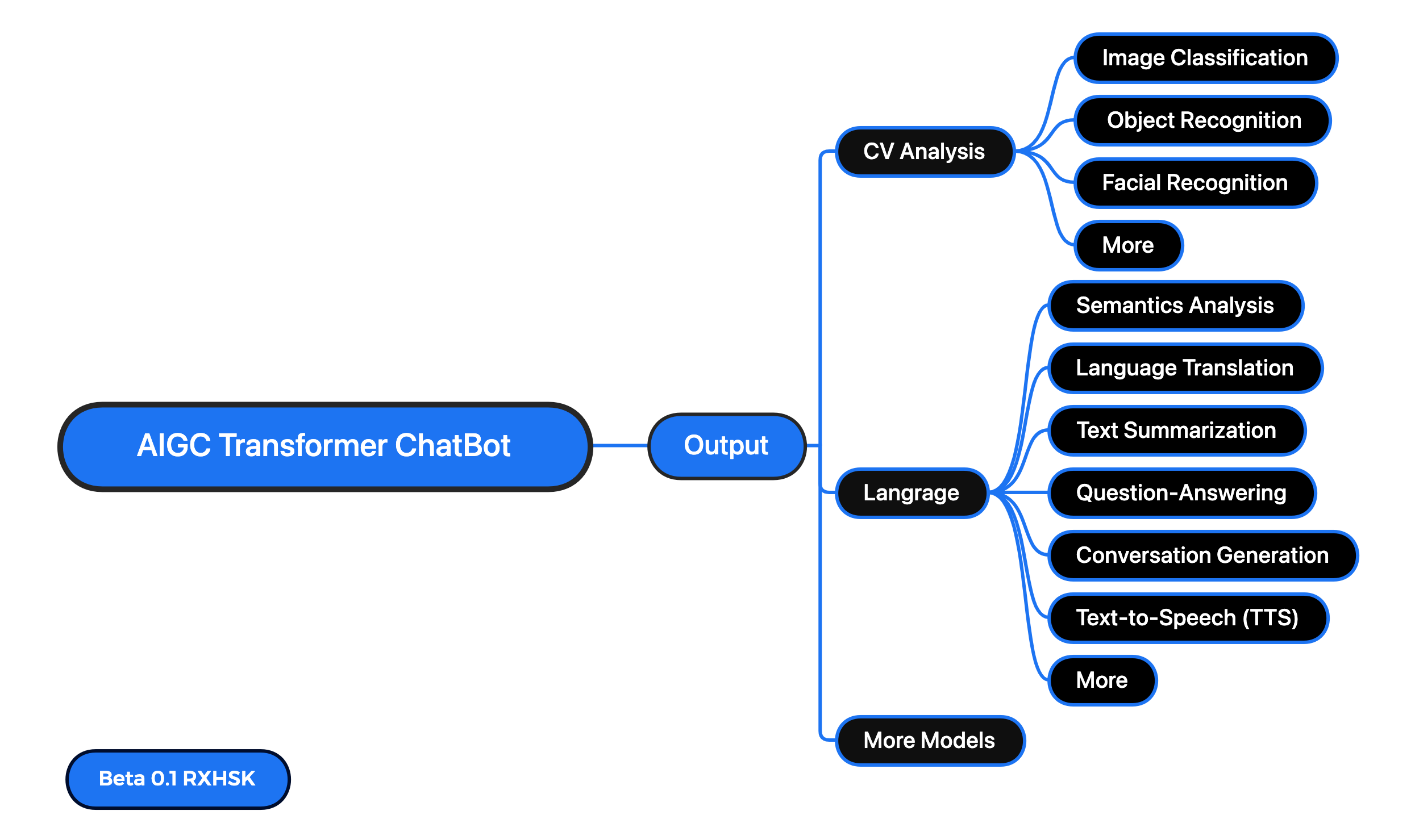

毫无疑问,自然语言处理(NLP)应用在每个人的日常生活中变得越来越重要。我们对AI能击的看法正在发生变化,例如,像新必应、Notion AI和OpenAI的ChatGPT这样的聊天机器人。人们使用它来写文章、编写代码、创作故事、规划旅程、学习新知识、获取在线建议,甚至控制机器人。而NLP的概念在很大程度上类似于人类使用和分析语言的方式。我未来的目标之一是构建通用人工智能(AGI),所以学习这些知识是非常必要和有趣的。我从中学到了很多有用的信息,包括我们可以在现有的NLP聊天机器人系统中进行的一些优化点。例如,为了让AI的响应更快,我们可以让模型在用户说话时预测他们的词。随着时间的推移,我们的模型可以更快地预测词,用户可以获得更好的用户体验。这与我们在课堂上学到的内容有联系。例如,新词会被保存在海马体中,正如我们在课堂上学到的,我们知道海马体是大脑中主要存储长期记忆的部分。在观看这个视频之前,我不知道为什么人类可以在如此短的时间内产生语言,现在我也意识到,在准确性和速度之间,尽可能快和低功耗有时是我们大脑的更优解。最后,我确实有一个问题,那就是在我们理解了所有这些知识之后,我们如何实际优化大型语言模型(LLM),让整个系统变得更好,最终帮助人类发现更好的知识系统。